Page 68 - 电力与能源2023年第六期

P. 68

614 关小宇,等:基于 WOA-BiLSTM 模型的短期光伏出力预测

电量。然而,以上算法存在算法复杂、需要花费大 在图 1 的在门控单元中,遗忘门 F t 负责确定

量时间寻找模型最优参数等问题。 需要遗忘的信息:

针对以上问题,本文提出一种基于鲸鱼优化 F t = σ (W f X t + U f H t - 1 + b f) (1)

算 法(WOA)与 双 向 长 短 期 记 忆 神 经 网 络(BiL⁃ 输入门 I t 决定了哪些信息需要被保留:

STM)的光伏出力短期预测模型。相较于长短期 I t = σ (W i X t + U i H t - 1 + b i) (2)

记忆神经网络(LSTM),BiLSTM 可以更好地捕 输出门 O t 决定了何时将细胞状态输出,再通

捉 序 列 数 据 中 的 上 下 文 信 息 。 本 文 首 先 使 用 过遗忘门和输入门的控制,能够更新细胞状态中

WOA 对 BiLSTM 的相关参数进行优化,再使用 的信息:

优 化 参 数 后 的 BiLSTM 对 光 伏 出 力 进 行 预 测 。 O t = σ (W o X t + U o H t - 1 + b o) (3)

试 验 结 果 表 明 ,相 较 于 传 统 的 LSTM 与 BiL⁃ 式中 W,U——各门控单元的权重;b——各门

STM,使用 WOA-BiLSTM 模型进行光伏出力预

控单元的偏置项; σ——Sigmoid 函数。

测可以显著地提升预测精度。

1.2 BiLSTM 模型

1 WOA-BiLSTM 模型构建 BiLSTM 是深度学习中一种常用的循环神经

网络(RNN)架构。BiLSTM 的基本结构可以分

1.1 LSTM 模型

为输入层、前向 LSTM、后向 LSTM、合并层与输

随着深度学习的快速发展,目前学术界提出

出层 5 个部分。前向 LSTM 由多个 LSTM 单元

了大量的预测模型,其中 LSTM 是一种用于处理

组成,通过时间步骤逐步处理输入序列数据。在

和预测时间序列数据的循环神经网络模型,是最

每个时间步骤中,输入数据和前一个时间步骤的

经典的深度学习预测模型之一,被广泛应用于时

隐藏状态经过一系列运算,得到经过门控操作后

间序列预测。LSTM 的核心思想是利用记忆单元

的输出。后向 LSTM 与前向 LSTM 层类似,也由

来存储和更新信息。每个记忆单元由一个细胞状

多个 LSTM 单元组成,但其以相反的时间顺序处

态和三个门(输入门、遗忘门、输出门)组成。这些

理输入序列数据,从而捕捉到相反方向的上下文

门通过可学习的权重来控制信息的流动,使得网

信息。合并层将前向 LSTM 层和后向 LSTM 层

络能够选择性地添加、删除或输出信息。

的输出进行合并。一种常见的合并方式是简单地

在 LSTM 中,输入门决定哪些信息需要更新

将对应时间步骤上的前向和后向输出连接起来,

并存储到记忆单元中,遗忘门决定哪些信息需要

形成一个更丰富的表示。根据任务的要求,输出

从记忆单元中删除,输出门决定从记忆单元中输

层可以在合并后的输出上应用不同的机制,如全

出何种信息。LSTM 通过这种门控机制,可以有

连接层、Softmax 层等,以产生最终的预测结果或

效 地 处 理 时 间 序 列 数 据 中 的 长 期 依 赖 关 系 。

生成序列。

LSTM 能够捕捉长距离的时间依赖,并且在反向

传播算法中能够减少梯度消失问题,从而提高网 BiLSTM 的输出表达式如下:

络的训练效果和泛化能力。 h t = Concat( h tf,h tb ) (4)

式 中 h t —— BiLSTM 隐 藏 层 ELU 状 态 ;

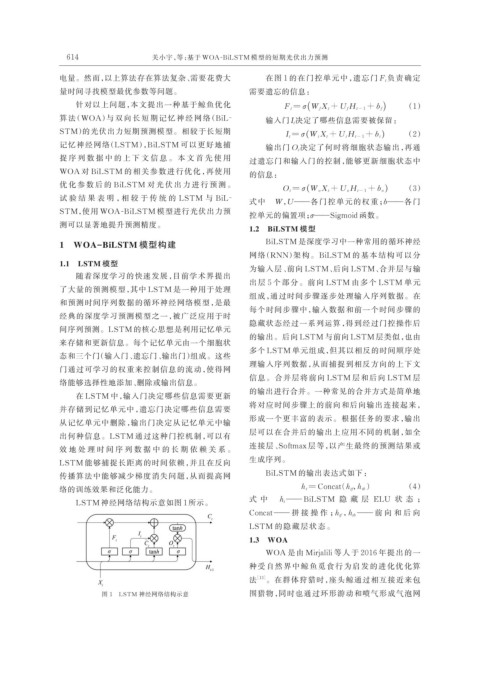

LSTM 神经网络结构示意如图 1 所示。

Concat —— 拼 接 操 作 ;h tf ,h tb —— 前 向 和 后 向

LSTM 的隐藏层状态。

1.3 WOA

WOA 是由 Mirjalili 等人于 2016 年提出的一

种受自然界中鲸鱼觅食行为启发的进化优化算

法 [13] 。在群体狩猎时,座头鲸通过相互接近来包

图 1 LSTM 神经网络结构示意 围猎物,同时也通过环形游动和喷气形成气泡网